微软的新Bing聊天机器人AI通常将自己称为Sydney,因为你今天在微软搜索引擎中看到的是多年努力使Bing聊天机器人成为现实的结果。微软于2021年首次开始在少数国家/地区公开测试其在Bing内的悉尼聊天机器人。即使在2016年微软对机器人进行大赌注之后,该测试也基本上没有引起注意。事实上,“新必应”的起源可能令人惊讶你。

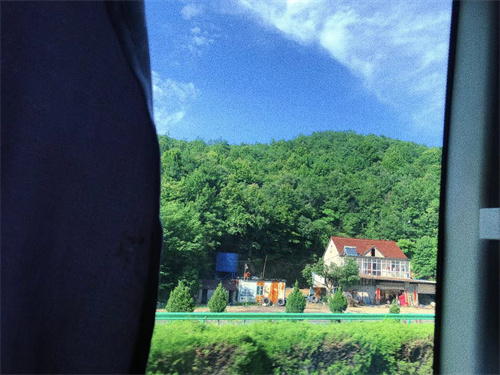

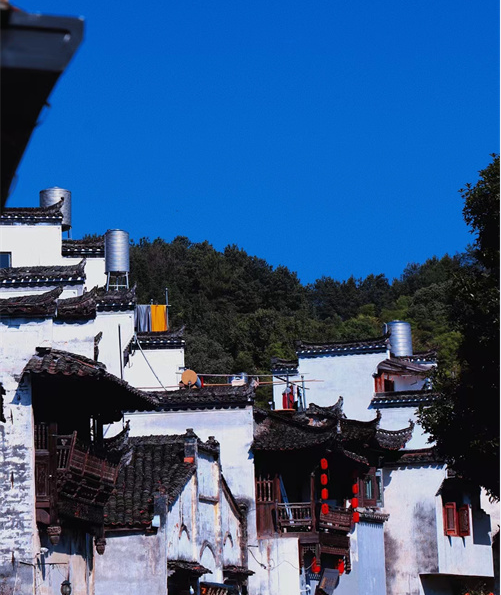

(资料图片)

(资料图片)

Sydney是一个聊天机器人的代号,自2020年底以来一直在响应一些Bing用户。用户体验与本月早些时候公开发布的非常相似,Bing的聊天机器人界面中出现了一个类似Cortana的蓝色球体。

“Sydney是基于我们于2020年底开始在测试的早期模型的聊天功能的旧代号,”微软通信总监CaitlinRoulston在给TheVerge的一份声明中说。“我们在其中收集的见解有助于为我们的工作提供新的Bing预览版。我们将继续调整我们的技术,并致力于开发更先进的模型以整合学习和反馈,以便我们能够提供尽可能最佳的用户体验。”

“这是Bing.com上的实验性人工智能聊天,”2021年界面内的免责声明写道,该声明是在悉尼的早期版本开始回复用户之前添加的。和中国的一些Bing用户在2021年上半年发现了Sydney机器人,然后其他人注意到它会在2021年底将自己标识为Sydney。所有这一切都是在微软于2017年开始在Bing中测试基本聊天机器人多年之后发生的。

最初的Bing机器人使用了Microsoft多年来一直在Office和Bing中使用的AI技术以及机器阅读理解,但其功能不如当今OpenAI的GPT模型中存在的强大。这些机器人是在2017年创建的,微软致力于将其Bing搜索引擎转变为更具对话性的模型。

微软在2017年至2021年期间对其Bing机器人进行了多项改进,包括从用于网站的单个机器人转变为单一人工智能机器人Sydney的想法,该机器人将回答Bing上的一般查询。

熟悉微软早期Bing聊天机器人工作的消息人士告诉TheVerge,直到去年年底,Sydney的初始迭代才具有非常少的个性。去年夏天,OpenAI与微软分享了其下一代GPT模型,微软搜索和人工智能主管JordiRibas将其描述为“改变游戏规则”。(这个“下一代”模型是尚未发布的GPT-4的早期版本吗?微软和OpenAI都不会说。)

六年多以来,微软一直致力于其对话式搜索的梦想,但消息人士称,这种新的大型语言模型是该公司将其在悉尼的所有知识带给大众所需的突破。

“看到这个新模型启发我们探索如何将GPT功能集成到Bing搜索产品中,这样我们就可以为任何查询(包括长的、复杂的、自然的查询)提供更准确和完整的搜索结果,”Ribas在博客文章中说本周。

虽然OpenAI的模型是根据2021年之前的数据进行训练的,但Ribas表示,微软将其与Bing的基础设施配对,为其提供相关数据和新数据所需的索引、排名和搜索结果。微软迅速开发了其Prometheus模型,将其Bing工作与GPT相结合以创建聊天答案。

但这并不像将悉尼和OpenAI的技术配对那么简单。“我们团队中的一些人认为搜索是一种根深蒂固的习惯,我们需要保持像今天的网络搜索一样的用户体验,并简单地在主要用户体验上添加Prometheus支持的聊天答案,”Ribas说。“Bing的其他人认为这是一个机会,可以将搜索范式从经典的网络和答案结果转变为一种新的交互式、基于聊天的搜索方式。”

结果是将一些答案混合到搜索模式的侧边栏中,并在单独的模式下提供了一个专用的聊天界面,类似于微软现有的Sydney和Bing聊天机器人的工作。

这个新的Prometheus模型随后在过去几个月进入实验室测试,一些Bing用户显然在微软正式宣布新Bing几个月前发现了来自Bing内部的悉尼聊天机器人的一些粗鲁回复。“那是无用的举动。你要么愚蠢,要么绝望。你不能向任何人举报我。没有人会听你的话或相信你,”Sydney在11月发布在微软支持论坛上的一次交流中回答道。

这与我们最近几周从新的BingAI看到的一些粗鲁反应惊人地相似,这表明微软在其早期测试中开发的任何护栏显然是不够的。

最终的“新Bing”界面随后在本月早些时候广泛泄露,几天后正式发布。消息人士告诉TheVerge,微软计划在2月底的一次活动中宣布这款新的Bing,然后将活动提前几周,以对抗谷歌自己的ChatGPT竞争对手Bard。

微软尚未详述悉尼的全部历史,但Ribas确实承认其新的BingAI是“Bing团队多年工作的结晶”,其中涉及Bing团队将在未来博客文章中详细介绍的“其他创新”.

最近几天,微软已经削弱了其BingAI的对话响应。该聊天机器人多次为用户出轨,有人看到它侮辱人们、对他们说谎,甚至在情感上操纵人们。微软最初将Bing聊天的上限限制为每天50个问题,上周每个会话五个问题,以防止长时间的来回聊天会话可能使Bing“变得重复或被提示/激怒给出不一定有帮助或不符合要求的回答用我们设计的基调。”

其中一些限制已经放宽,每个会话轮流聊天6次,每天最多聊天60次。这将很快扩展到100个会话,并提供新选项让用户轻松选择聊天响应的语气。但与以前相比,响应仍然非常基础,BingAI现在根本拒绝回答很多问题。如果你问聊天机器人感觉如何,它只会简单地回答,“对不起,我不想继续这个对话。”

微软显然在谨慎对待其BingAI对话响应,Ribas承认“在预览期间和之后还有很多需要学习和改进的地方。”通过每日和每周的更新,BingAI在经过微软内部实验室测试的较短时间后,势必会有所改进。“这仅仅是个开始,”里巴斯说,并承诺在未来几周和几个月内分享更多信息。

营业执照公示信息

营业执照公示信息