跟进我们之前的故事,由于ChatGPT的日益普及,预计NVIDIA的GPU增长将在未来几个月加速。NVIDIAAIGPU可能面临短缺,因为AI巨头使用ChatGPT和其他AI生成工具的需求增加

(资料图片)

(资料图片)

如前所述,ChatGPT和其他语言/图像/视频生成工具严重依赖AI处理能力,这就是NVIDIA的主要优势所在。这就是为什么利用ChatGPT的主要科技公司正在利用NVIDIA的GPU来满足他们不断增长的AI需求。看起来NVIDIA在这个行业的实力可能会在未来几个月内导致该公司的AIGPU短缺。

据报道凶猛电子,ChatGPT(Open.AI年的测试版)在NVIDIA的10,000个GPU上进行训练,但自从它获得公众关注以来,该系统一直不堪重负,无法满足大量用户群的需求。这就是为什么该公司宣布了一项新的ChatGPTPlus订阅计划,该计划不仅将在高峰时段提供对服务器的一般访问,而且还提供更快的响应时间和优先访问新功能和改进。ChatGPTPlus订阅的价格为每月20美元.

“未来,ChatGPT或其他深度学习模型可能会在其他供应商的GPU上进行训练或运行。然而,目前,NVIDIAGPU由于其高性能和CUDA支持而在深度学习社区中被广泛使用。CUDA是由NVIDIA開發的平行計算平台和編程模型,允許在NVIDIAGPU上進行高效計算。许多深度学习库和框架,如TensorFlow和PyTorch,都内置了对CUDA的支持,并针对NVIDIAGPU进行了优化。

通过凶猛电子

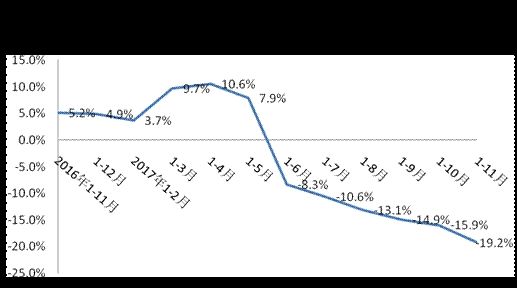

到目前为止,NVIDIA已为GeForceRTX100显卡出货了000,102个AD4090“Ada”GPU2

微软和谷歌等主要科技巨头也计划将类似ChatGPT的LLM集成到他们的搜索引擎中。福布斯.对于谷歌来说,要将其集成到每个搜索查询中,将需要512,820台A100HGX服务器,总共4,102,568个A100GPU,仅服务器和网络成本就应该达到约100亿美元的资本支出。

将当前的ChatGPT部署到Google完成的每个搜索中将需要512,820.51台A100HGX服务器,总共4,102,568台A100GPU。这些服务器和网络的总成本仅资本支出就超过100亿美元,其中英伟达将获得很大一部分。当然,这永远不会发生,但是如果我们假设没有进行任何软件或硬件改进,那么有趣的思想实验。

Investing.com据报道,分析师预测,ChatGPT的当前模型正在大约25,000个左右的NVIDIAGPU上进行训练,而BETA使用的是10,000个NVIDIAGPU。

“我们认为GPT5目前正在25kGPU上进行训练-225美元左右的NVIDIA硬件-推理成本可能远低于我们看到的一些数字,”分析师写道。“此外,降低推理成本对于解决云巨头的"搜索成本"争论至关重要。

这对NVIDIA来说可能是个好消息,但对消费者来说并不是那么好,尤其是游戏玩家。如果NVIDIA在其AIGPU业务中看到机会,它可能会优先考虑供应这些而不是游戏GPU。游戏GPU已经报道由于农历新年,本季度供应有限,虽然库存仍然存在,但这可能会给已经稀缺的高端GPU带来问题。此外,高端GPU还提供更高的AI功能,因为服务器部件的价格要低得多,它们可能成为一个有利可图的选择,进一步减少游戏玩家的供应。

英伟达如何应对人工智能领域的这一巨大需求还有待观察。预计GPU巨头将公布4财年第四季度收益22年2023月<>日。

营业执照公示信息

营业执照公示信息